Harmonogram wzorcowania – porównanie ILAC G24 z FD X07-014. Optymalizacja okresów wzorcowania metodą OPPERET.

Witajcie,

Postanowiłem dziś wrócić do wiecznie gorącego tematu, mianowicie metod ustalania okresów ważności wzorcowania przyrządów pomiarowych. Harmonogram wzorcowania to temat interesujący o tyle, że z jednej strony dotyczy w zasadzie wszystkich, którzy pracują w oparciu o nowoczesne systemy zarządzania, z drugiej zaś nie da się opracować i wdrożyć jednej uniwersalnej metody, która da się zastosować stuprocentowo skutecznie w każdym przedsiębiorstwie. Poruszamy się raczej w obszarze zaleceń i przykładów, ale finalnie i tak każda organizacja musi rozwiązać problem sama.

Kolejnym powodem, dla którego odświeżam tę kwestię raz jeszcze jest coraz powszechniejsze myślenie i działanie w kontekście analizy ryzyka. Co ciekawe jedna z metod, która doskonale wpisuje się w ten trend, jest z jakiegoś powodu u nas kompletnie nieznana (przynajmniej ja w praktyce się nie spotkałem) i głównie ją chciałbym Wam przybliżyć.

Na wstępie zaznaczyć należy, że oczekiwania i podejście do prezentowanego zagadnienia będą zupełnie różne dla laboratoriów pracujących zgodnie ze standardem ISO/IEC 17025, oraz dla firm produkcyjnych działających w oparciu o ISO 9001. Wśród tych drugich z kolei branża i skala będą czynić dalszą, ogromną różnicę, niemniej coś postanowić trzeba i postanowień tych przestrzegać.

Dokumenty i wytyczne

Jak już wspomniano, nie ma normy która narzucałaby jasne wytyczne czy wymagania w zakresie długości interwałów. Chcąc zdobyć wiedzę w tym obszarze natrafimy raczej na zalecenia i przewodniki. Prześledźmy pewien łańcuch powiązań:

Samo wymaganie „wzorcowania i/ lub sprawdzania w ustalonych odstępach czasu lub przed użyciem” pojawia się w ISO 9001, punkt 7.1.5.2.

Norma ta wskazuje z kolei ISO 10012 jako źródło szczegółowych wytycznych. Odnajdujemy tam punkt 7.1.2, gdzie dowiadujemy się, że przyjęte do ustalenia okresów metody powinny być udokumentowane a same odstępy weryfikowane i dostosowywane. Znajdziemy też kolejne odwołanie do dokumentu zewnętrznego – tym razem OIML D10/ ILAC G24 Wytyczne dotyczące wyznaczania odstępów czasu między wzorcowaniami przyrządów pomiarowych. Wprawdzie sam dokument dotyczy laboratoriów, ale przecież to one są źródłem dobrej praktyki, poza tym cel mamy wspólny: zachowanie spójności pomiarowej.

Omawiane w przewodniku metody są powszechnie znane, umówmy się jednak szczerze – ich opracowanie jest więcej niż lakoniczne, są w zasadzie wymienione z nazwy i scharakteryzowane, niektóre z nich okraszono odnośnikami zewnętrznymi (metody statystyczne).

Tymczasem istnieje ciekawy francuski dokument FD X07-014 Métrologie – Optimisation des intervalles de confirmation métrologique des équipements de mesure, z którym jak dotąd w praktyce nie spotkałem się na ojczystej ziemi, a który to jest pełen ciekawych informacji i zaleceń. W dodatku bardzo konkretnych!

Kiedy harmonogram wzorcowania jest skuteczny?

Zanim przejdziemy do prezentacji i porównania metod znanych i nieznanych zacznijmy od określenia symptomów świadczących o tym, że nasze przyrządy pomiarowe są kalibrowane odpowiednio często.

- Podczas kolejnych sprawdzeń wyniki potwierdzają przydatność urządzenia – wartości błędów mieszczą się w przyjętych kryteriach. Jeśli podczas wzorcowania stwierdzamy przekroczenie dopuszczalnych błędów świadczy to o tym, że przyrząd sprawdzany jest zbyt rzadko. Nieznany pozostaje okres, w którym urządzenie generowało błędne wyniki pomiarów.

- Proces nie generuje nadmiernych kosztów związanych ze zbyt częstą kalibracją. Tu sprawa jest delikatniejsza i wymaga precyzyjnej oceny, ale jeżeli obserwacja wyników kolejnych sprawdzeń wykazuje, że błędy pozostają na niezmienionym poziomie, można zaryzykować wydłużenie okresu. Decyzja ta nie może być oderwana od oceny istotności procesu, w którym przyrząd uczestniczy.

Stałe okresy między wzorcowaniami

Najpowszechniejsza jest metoda najgorsza z możliwych.

Życie

Pomijając wymagające branże (a i to nie zawsze) najczęściej spotykana jest metoda stałych okresów między wzorcowaniami. Jej najczarniejsza wersja to po prostu sprawdzanie wszystkich narzędzi, bez podziału na grupy, warunki stosowania czy istotność procesu pomiarowego, co stałą liczbę miesięcy czy lat. W zasadzie jej stosowanie może się sprawdzić jedynie w małych firmach, bez wymagających, precyzyjnych procesów…

Ważne założenie: harmonogram kalibracji nie powinien być niezmienny. Należy traktować go jako coś żywego, podlegającego ciągłym modyfikacjom.

Przyjęcie tego podejścia jest krokiem naprzód w dobrą stronę. Możemy zacząć na przykład od analizy skuteczności naszego harmonogramu raz do roku.

Nieco lepszą odmianą metody stałych okresów jest jej dopasowanie do realiów naszego przedsiębiorstwa, przez co będzie ona nosić znamiona skuteczności. Polega ona na tym, że okresy wprawdzie nadal są stałe, ale różne, a różnice te oparto na analizie czynników wpływających.

Czynniki wpływające na okresy wzorcowania

Ustalając dopuszczalne odstępy między wzorcowaniami powinniśmy rozważyć poniższe czynniki wpływające na grupę bądź dany egzemplarz:

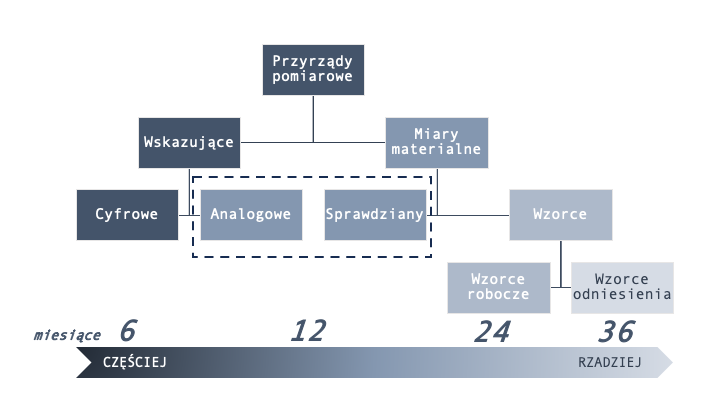

- rodzaj przyrządu: przyrządy wskazujące z reguły sprawdzać należy częściej niż miary materialne

- warunki użytkowania: przyrządy na produkcji z reguły sprawdzamy częściej niż np. z laboratorium

- użytkownik przyrządu, stopień wyszkolenia: ogólnodostępne narzędzia sprawdzamy częściej niż użytkowane przez personel laboratorium

- istotność procesu pomiarowego: narzędzia mierzące krytyczne cechy powinny być monitorowane częściej

- jakość i trwałość

- zalecenia producenta

- dane historyczne

- doświadczenie własne organizacji

Analizując powyższe możemy stworzyć przykładowy harmonogram, który wprawdzie uwzględnia jedno tylko kryterium, ale jednak:

W tym przykładzie przyjęto, że miary materialne sprawdzamy rzadziej, ale wskazujące dalej podzielono na cyfrowe i analogowe.

Przejdźmy zatem do przedstawienia metod, począwszy od serwowanych przez ILAC G24.

Zmiana automatyczna lub schodkowa

W metodzie tej wydłuża się interwał kalibracji jeśli w trakcie wzorcowania znaleziony błąd znajdzie się w ustalonych granicach np. 80% wartości maksymalnej lub skraca gdy wartość błędu przekroczy ten próg. Oczywistą wadą metody jest traktowanie każdego przyrządu indywidualnie, co może być problematyczne przy dużej ich ilości. Do rozważenia pozostają kwestie uwzględniania niepewności pomiaru oraz ustalenia wartości bezpiecznej.

Karta kontrolna

Metoda statystyczna, możliwa do stosowania w zasadzie jedynie z wykorzystaniem oprogramowania, najlepiej w systemach SPC. Wybierane są punkty podlegające monitorowaniu, dla których w funkcji czasu wylicza się rozrzut i dryft. Wyniki te są podstawą do określenia optymalnego okresu między wzorcowaniami.

Czas pracy przyrządu

W metodzie tej bazujemy na rzeczywistym czasie użytkowania przyrządu. Nie opiera się ona więc na interwałach miesięcznych czy rocznych, a w zasadzie na roboczogodzinach. Zwróćmy uwagę, że operowanie czasem kalendarzowym ma tę niedoskonałość, że przyrząd jest kalibrowany w ustalonym terminie zarówno jeśli był użytkowany intensywnie jak sporadycznie lub wcale. Oczywiście sprawna gospodarka narzędziami, w tym monitorowanie użycia powinna takie sytuacje sygnalizować.

Nadzorowanie czasu pracy urządzeń pomiarowych wymaga ponownie wspomagania komputerowego lub zegarów, co generuje koszty. Z drugiej strony stosowanie tej metody z reguły prowadzi do zmniejszenia kosztów poprzez rzadsze w ujęciu kalendarzowym wzorcowania. Po stronie wad zapisać należy także utrudnioną logistykę i planowanie samych wzorcowań, zwłaszcza zewnętrznych, gdyż ich regularność zostaje uzależniona od częstotliwości stosowania.

Czarna skrzynka

Przewodnik wskazuje, że najlepszymi obiektami do stosowania metody czarnej skrzynki są złożone urządzenia testujące. Potwierdzenie prawidłowości wskazań urządzenia odbywa się poprzez zastosowanie specjalnego urządzenia wzorcującego, które sprawdza krytyczne parametry. Jeśli wynik sprawdzenia jest pozytywny urządzenie uznane jest za zgodne, w przeciwnym wypadku kierowane jest do wzorcowania. Zaletą tej metody jest możliwość sprawdzenia urządzenia w dowolnym momencie. Nie należy jednak traktować jej jako stałego zamiennika pełnego wzorcowania – raczej jako narzędzie kontrolne w przypadku wątpliwości. Niemniej może ono być użyteczne w celu zbierania danych umożliwiających doświadczalne określenie docelowego harmonogramu

Inne metody statystyczne

Dalej przewodnik odsyła do innych metod statystycznych, którym poświęcić wymaga osobny artykuł. Mamy bowiem wiele metod empirycznych opartych na działaniach matematycznych i analizie regresji, w wyniku których otrzymujemy pożądaną, teoretycznie najlepszą wartość odstępu między wzorcowaniami lub ocenę w postaci utrzymać/ skrócić/ wydłużyć. Niektóre podejścia wykorzystują do tego analizę ilości wyników nieakceptowalnych (metoda trzech kalibracji czy metoda Schumachera), inne wykorzystują potencjał kart kontrolnych. Metody statystyczne do punktu wyjścia i obliczeń wykorzystują % niezgodnych wyników wzorcowań i to podejście występuje także w dokumencie francuskim, który krótko zaprezentuję poniżej.

A co na to FD X07-014?

A no właśnie, bo przecież wpis nie miał być o tym co każdemu znane… Francuski dokument odnosi się oczywiście do metod wspomnianych w ILAC G24, w stosunku do których podaje więcej konkretów i przykładów, jednak nie na prezentacji podobieństw mi zależy. Ogólnie – jako całość – różnica tkwi niejako w podejściu – jest bardziej praktyczny i zakorzeniony w duchu ISO 10012. Dla mnie to wystarczająca zachęta.

Gdy tylko dany sprzęt pomiarowy zostanie oddany do użytku, proponowane podejście wymaga równoległego przeprowadzenia następujących czynności:

- analizy przydatności do procesu pomiarowego w docelowych warunkach

- poznania i zrozumienia zasad działania przyrządu, w tym cech technologicznych

- monitorowania wydajności sprzętu i utrzymywania tego monitorowania przez cały okres jego użytkowania

- analizy zachowania sprzętu z tej samej rodziny już używanego w podobnych warunkach.

Tu zróbmy pauzę – podobnie jak w ILAC G24 mowa jest o tym, że nieco inne narzędzia statystyczne zastosujemy w odniesieniu do pojedynczego egzemplarza, a nieco inne pozwolą nam na optymalizację okresów wzorcowania dla grup narzędzi.

Podstawowe założenia, które pozwalają na optymalizację interwałów wzorcowania są następujące:

- ustalono właściwie MPE najlepiej w kontekście ograniczenia ryzyka

- dysponujemy historią wzorcowań w postaci wyników, a nie jedynie oceną zgodny/ niezgodny

- przeprowadzono potwierdzenie metrologiczne a najlepiej także ocenę ryzyka

Zwróćmy tylko uwagę, iż mowa jest o „optymalizacji okresów wzorcowania”, co implikuje konieczność przyjęcia interwału wstępnego dla np. nowego narzędzia a następnie jego modyfikację w oparciu o metody w normie prezentowane. Podobnie zresztą trudno zastosować strategie obliczeniowe do nowych urządzeń, skuteczne metody bazują bowiem na zjawisku dryftu, które z kolei też może być rozpoznane z różną skutecznością – inaczej dla miar materialnych, inaczej dla przyrządów wskazujących… NA dodatek sam dryft może być mylący na przykład w sytuacji gdy w trakcie życia przyrządu zmieniły się warunki jego użytkowania. Niemniej to właśnie obserwacja dryftu zdaje się być najbardziej efektywną miarą zużycia przyrządu, która zawiera w sobie wpływ wielu czynników – charakterystyk metrologicznych i konstrukcyjnych.

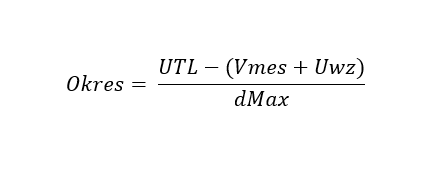

Punktem wyjścia do obliczeń zgodnie z metodą jest określenie dryftu maksymalnego oraz znajomość niepewności kalibracji. Norma podaje tu konkretne wzory, na przykład dla dMax dodatnich:

Gdzie:

- Okres – wartość optymalnego interwału wyrażona w tej samej jednostce czasu, którą przyjęto w analizie dryftu

- Vmes – zmierzona wartość badanej charakterystyki wyrażona w tej samej jednostce, którą przyjęto w analizie dryftu

- Uwz – niepewność wzorcowania

- dMax – dryft maksymalny

Praktyczne? Bardzo!

Jeśli nie dryft to co?

Tam, gdzie obserwacja dryftu nie może stanowić bezpiecznego punktu wyjścia do ustalania najlepszego interwału norma proponuje metodę opartą na ocenie czynników wpływających na proces pomiarowy pod kątem ich wagi. Analizując proces pomiarowy, można zidentyfikować elementy, które mają największy udział w niepewności i które można zmniejszyć poprzez zmiany procesu (zmiana częstotliwości kalibracji, zmiana sprzętu pomiarowego, zmiana laboratorium wzorcującego itp.). Następnie można zastosować następującą metodę, która polega na ocenie wagi wkładu badanego egzemplarza sprzętu w niepewność pomiaru procesu (procesów), w których bierze udział.

Zasada: Im mniejszy wkład sprzętu w niepewność pomiaru, tym większe odstępy między wzorcowaniami.

Po zakończeniu analizy powinniśmy już znać wkład egzemplarza w zmienność procesu. Dzięki temu możemy policzyć jego udział w ogóle zmienności. Po oszacowaniu niepewności procesu metoda polega na określeniu współczynnika okresowości, tj. stosunku wariancji związanej ze skalibrowaną charakterystyką badanego sprzętu pomiarowego.

Niezależnie od przyjętej metody ustalenia najlepszego czasokresu pamiętajmy, że jest ona początkiem a nie końcem procesu i po pierwsze sama podlega modyfikacjom, a po drugie wyniki kolejnych sprawdzeń i dryft muszą oczywiście być rejestrowane i analizowane.

Poniżej chciałbym przedstawić jeszcze jeden szczególnie interesujący punkt dokumentu jakim jest metoda OPPERET. Zwłaszcza, że przytoczone powyżej mają charakter stricte ilościowy.

„Operetka”

Pod tym melodyjnym i enigmatycznym zarazem skrótem kryje się francuskie: Optimisation des périodicités d’étalonnage, czyli nic innego jak po prostu optymalizacja okresów wzorcowania. Metoda wymaga zaangażowania większego zespołu, najlepiej przekrojowo ze wszystkich zaangażowanych w proces działów (coś na kształt FMEA). Nasuwa mi się od razu pewne porównanie:

Metoda OPPERET może być dla obliczeniowych metod ustalania interwałów tym, czym MSA jest dla niepewności pomiaru – praktycznym odpowiednikiem.

Zwróćmy uwagę, iż ocena ta ma charakter bardziej jakościowy.

Kolejne kroki procesu to:

- określić czynniki podlegające ocenie (wymagania procesu, wpływ dryftu, koszty kalibracji, istotność procesu)

- ustalić punktową skalę oceny (na przykład skala -2/0/2 od największego do najmniejszego ryzyka)

- przypisać czynnikom wagi (1, 2, 3)

Metoda OPPERET wskazuje 9 obszarów, które należy rozważyć – niektóre z tych elementów są ilościowe, inne jakościowe i oczywiście różnią się znaczeniem. Są to:

- Konsekwencje niepoprawnego pomiaru

- Zdolność procesu pomiarowego

- Zdolność sprzętu pomiarowego

- Dryft

- Historia użycia sprzętu

- Możliwość wykrycia anomalii sprzętu

- Czynniki obciążające

- Ograniczenia kosztowe

- Ograniczenia operacyjne

Ocenę taką wygodnie sporządzimy w tabelce, a następnie po zastosowaniu opisanego w dokumencie wzoru matematycznego otrzymamy wynik będący wartością opisującą teoretycznie najlepszy interwał.

Metoda OPPERET może być stosowana i znakomicie sprawdzi się w ocenie większych grup narzędzi.

W tym celu – poza ich pogrupowaniem naturalnie, konieczna może być punktacja i ważenie pewnej populacji a następnie wyciągnięcie wartości średniej. Ma to choćby miejsce w sytuacji, gdzie ta sama grupa narzędzi bierze udział w procesach różnej istotności.

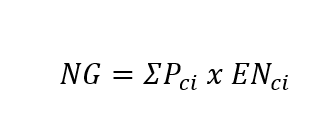

Obliczenia w metodzie bazują na odchyleniach standardowych. Po określeniu odchyleń standardowych ogólny wynik dla sprzętu jest obliczany przy użyciu wzoru:

Gdzie:

- Pci oznacza współczynnik ważenia dla kryterium Ci

- ENci oznacza odchylenie standardowe dla kryterium Ci

Gdybyśmy byli w stanie poznać optymalną wartość dla odstępu między wzorcowaniami dla każdego sprzętu w grupie, to rozkład tych okresowości byłby rozkładem normalnym. Jeśli grupa podlega jednakowemu harmonogramowi i zidentyfikowaliśmy % niezgodnych wzorcowań na poziomie 3%, to odpowiada to odległości ok. 2 odchyleń standardowych od średniej okresowości. Podobnie, możliwe jest ustalenie maksymalnej akceptowalnej okresowości dla danej grupy. Można oszacować, że ta maksymalna wartość jest odpowiednia dla ponad 99% rodziny i dlatego znajduje się na poziomie trzech odchyleń standardowych od średniej optymalnego interwału.

Następnie obliczamy wartość odchylenia standardowego s rozkładu optymalnych okresowości oraz optymalny średni interwał. Zakładając, że rozkład optymalnej okresowości i rozkład ogólnych ważonych wyników są „nakładające się”, możliwe jest określenie korekty okresowości. I na to wszystko w normie mamy piękne, proste wzory:)

Wynikiem analizy zatem jest współczynnik pozwalający skorygować dotychczasowy interwał o jego wartość, która może być tak dodatnia (wydłużenie interwału) jak i ujemna (skrócenie). Zaletą metody jest otrzymanie konkretnej wartości liczbowej w jednostce czasu – na przykład -13 miesięcy.

Quo Vadis?

Celem, który chcemy osiągnąć jest opracowanie skutecznego modelu predykcyjnego, który pozwoli skutecznie określać najlepszy harmonogram kalibracji, minimalizujący ryzyko otrzymania wyników niezgodnych przy jednoczesnym uwzględnianiu relacji częstotliwości do kosztów. Póki co mamy dość wyraźny rozdźwięk między metodami nadającymi się bardziej dla laboratoriów od tych bardziej produkcyjnych. Niektóre z metod z kolei nadają się bardziej do ustalenia właściwego harmonogramu pojedynczych sztuk przyrządów niż całych grup, inne odwrotnie. Finalnie wszystko spada na nasze barki i to właśnie na własnym doświadczeniu zbudować powinniśmy system maksymalnie skuteczny.

Przytoczona w artykule metoda zdaje się znakomicie wpisywać w podejście związane z analizą ryzyka. Jej stosowanie wymaga naturalnie doświadczenia i ostrożności, niemniej jeśli w organizacji pojawia się taka potrzeba – o czym zresztą świadczy to, że odnalazłeś ten artykuł – zapraszam do współpracy, szkolenia i wdrożenia metody u Ciebie.